中国建筑设计研究院有限公司 韩武松 郑坤 郭然 摘要: 随着数据中心的发展,其冷却能耗占总能耗40%以上。提高数据中心机房温度能够有效降低数据中心总能耗,但提高机房温度是否对IT系统的安全和寿命产生负面影响?对提高数据中心能效和降低能耗的贡献到底有多少?本文对这两个问题进行分析,结合资料调研、分析计算和实际案例,指出提高数据中心机房温度对服务器可靠性影响较小,能够降低空调系统能耗

中国建筑设计研究院有限公司

韩武松 郑坤 郭然

摘要: 随着数据中心的发展,其冷却能耗占总能耗40%以上。提高数据中心机房温度能够有效降低数据中心总能耗,但提高机房温度是否对IT系统的安全和寿命产生负面影响?对提高数据中心能效和降低能耗的贡献到底有多少?本文对这两个问题进行分析,结合资料调研、分析计算和实际案例,指出提高数据中心机房温度对服务器可靠性影响较小,能够降低空调系统能耗 。

关键词: 高温数据中心 空调 冷热通道 温度提升 节能

引言

伴随全球信息化的发展,数据中心作为数据存储和交互的基础设施,其发展备受瞩目。当前,在能源、环境与经济问题严峻的国际背景下,数据中心被称为“能源黑洞”,它的节能问题受到高度关注。

我国数据中心的规模和数量快速增长。根据工业和信息化部电信研究院调研统计数据,2015年我国数据中心耗电量达到了1000亿kW·h,已达全社会总用电量的1.5%,相当于当年天津市的耗电量,这个比例还在不断快速上涨。据统计,到2017年底,我国在用数据中心达到1844个,机架总体规模达到166万架,规划在建数据中心463个,机架规模107万架,比2016年增长10%,预计未来占比会进一步提高。

传统数据中心机房温度在18℃~23℃。如果将数据中心机房温度提高5℃,其能耗将降低8%,可以节省电量243亿kW·h,相当于西班牙、南非、澳大利亚或中国台湾超过一个月的用电量,减排的二氧化碳为170万吨,相当于430万棵树成长10年所吸收的二氧化碳 [1] 。

当前数据中心能源效率的评价一般采用PUE指标。提高数据中心机房温度,直接带来的效果就是降低数据中心的PUE值。PUE为数据中心总设备能耗(包括IT设备和通风空调设备、照明、控制、配电损耗等的能耗)与IT设备能耗的比值,越接近于1说明数据中心用电效率越高,配套的供电、空调系统能耗比例越小,能效水平就越高。目前全球数据中心的平均PUE值为2.0,发达国家约为1.5~1.8,我国80%以上的数据中心PUE值大于2.0,有的甚至高达3.0 [2] 。

高温数据中心(high ambient temperature(HTA)data center) [1] 是Intel提出的一种数据中心设计概念。高温数据中心是将各种IT设备放置在比传统数据中心机房温度更高的地方进行工作。其做法是将数据中心机房温度(冷通道的平均温度)从传统的20℃左右提高至30℃(甚至更高)。从空调系统角度考虑,这种设计突破传统温度的限制,能够较大幅度降低数据中心空调系统能耗,降低PUE值。笔者针对数据中心的高温运行对服务器、电源等设备的安全和寿命的影响进行分析。

1.数据中心节能潜力分析

数据中心机房温度设计标准和现状

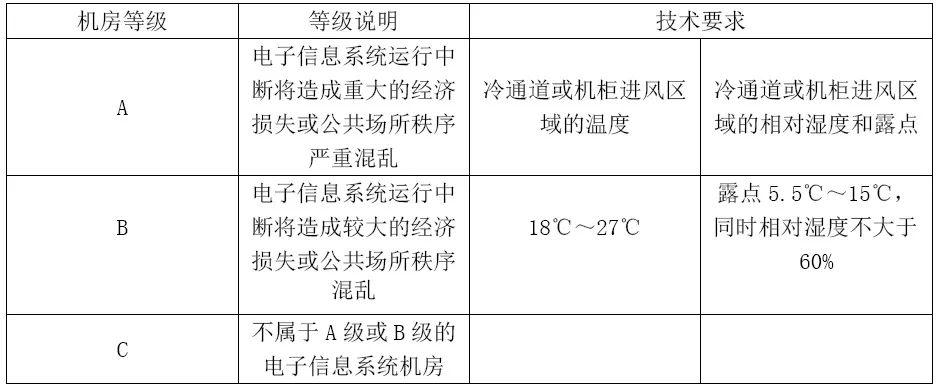

数据中心机房温度设计是数据中心空调系统设计的一个基础。我国GB 50174—2017《数据中心设计规范》 [3] 将机房划分为A,B和C3个等级,室内环境设计参数如表1所示。

表1 我国数据中心机房温湿度设计标准

美国数据中心设计遵从TIA-942-2010 Telecommunications Infrastructure Standard for Data Centers将机房分为TIER1,TIER2,TIER3和TIER4四个等级,从1~4等级依次升高,但其室内环境设计参数均相同,如表2所示 [4] 。

表2 美国数据中心机房温湿度设计标准

美国制冷空调供暖工程师学会(ASHRAE)于2004年出版了《数据处理环境热指南》(Thermal Guidelines for Data Processing Environments),至今已经做了数次修改,2011版规定的机房设计温度如表3所示 [5] 。

表3 ASHRAE推荐机房温湿度设计标准

注:室外湿球温度≥10℃时制冷机组运行;5℃<室外湿球温度<10℃时,采用部分自然冷却方式;室外湿球温度≤5℃时,采用完全自然冷却方式。以机房温度23℃为基准。

由表3可以看出,ASHRAE对数据中心机房温度设计范围进行了调整,推荐值上限提高到27℃,还将最高允许温度根据Al~A4不同等级提高至32℃~45℃。

数据中心机房温度与能耗的关系

数据中心的主要能耗单元是服务器和空调系统,两者能耗占了数据中心总能耗的90%左右。由于UPS(不间断电源)和照明所占能耗比例较小,同时并没有研究表明机房温度对这两者的能耗有明显影响,故在此不予考虑。笔者将分别研究数据中心机房温度与服务器和空调系统能耗的关系。

数据中心机房温度对服务器能耗的影响主要在散热风机、电路和转换损失上。随着机房温度的升高,风机转速增大,风机的耗电量增大。服务器能耗随服务器入口空气温度的变化如图1所示 [4] 。

图1 服务器的能耗随入口空气温度的变化

由图1可知,随着服务器入口空气温度的提高,服务器能耗升高,而且随着空气温度的上升,能耗升高速率加快。

数据中心机房室内设计温度的提高对空调系统能耗的影响主要表现在以下3个方面:

(1)室内设计温度的提升能够减小机房围护结构的冷负荷从而降低空调系统能耗;机房室内设计温度的提高,有助于提高机房空调机组的显冷量,潜热量的减少意味着除湿量的减少,减少了机房的湿负荷,减少了机房空调的加湿运行及其运行成本。

(2)室内设计温度的提升允许室内采用较高的送风温度,从而提高冷水机组或者直接蒸发空调机组的蒸发温度,由此可以提高空调机组的能效比,降低其能耗。一般冷水机组出水温度提高1℃,能效比可提高约3%,在保证制冷量满足需求的情况下,将冷冻水温度从7℃提高至12℃甚至更高,冷水机组可节约15%以上的能耗。

(3)室内设计温度的提升允许室内采用较高的送风温度,提高冷冻水温度后,我国大部分地区数据中心可以常年采用自然冷却而无须开启空调机组,从而延长冷却塔供冷、空气冷却器等自然冷却措施的使用时间,实现自然冷源梯级利用,缩短电制冷空调的使用时间,降低能耗。根据《中国建筑热环境分析专用气象数据集》中北京、上海、呼和浩特3个地区的典型气象年逐时气象参数统计得到的数据中心机房自然冷却时间分布及比例如表4所示。

表4 北京、上海、呼和浩特3个地区数据中心机房自然冷却时间分布及时间占比

由表4可以看出,当数据中心机房室内设计温度提高3℃,北京地区冷水机组运行时间减少704h,上海地区减少931h,呼和浩特减少815h。冷水机组运行时间的缩短就意味着自然冷却时间的延长。以北京为例,自然冷却时间由3050h延长至3756h,提高了23.15%,假设采用部分自然冷却时机组平均能耗是额定工况下能耗的60%,基准运行情况下的节能率为40.7%,提高3℃后,此冷水机组全年能耗降低了8.1%。

提高数据中心机房温度的节能效果

由上述分析可知,数据中心机房温度的提高将增大服务器的能耗,降低空调系统能耗,因此机房温度对数据中心能耗的影响需要综合两者考虑。假设数据中心初始机房温度为23℃,服务器能耗和空调系统能耗占数据中心总能耗的90%,则机房温度分别提高至27℃和30℃时,数据中心总能耗随服务器能耗与空调系统能耗比值的变化情况如图2所示 [5] 。

由图2可知,机房温度的提高能够有效降低数据中心总能耗,机房温度提高幅度越大,数据中心的能耗降低幅度越大,且该值随着服务器能耗与空调系统能耗比值的增大而减小。当服务器能耗与空调系统能耗相同,机房温度分别提高至27℃和30℃时,数据中心总能耗分别降低6.5%和10.5%。当服务器能耗是空调系统能耗的1.2倍,机房温度分别提高至27℃和30℃时,数据中心总能耗分别降低5.5%和9.0%。

图2 数据中心总能耗随服务器能耗与空调系统能耗比值的变化

2.提高数据中心机房温度的可行性

对空调和UPS系统寿命与安全的影响

提高数据中心机房温度对空调系统的运行安全并无影响,但是提高机房温度对UPS系统,尤其是UPS电池的影响较大,一般UPS电池的最佳使用温度不超过30℃,一旦超过该值,电池的自放电过程会加速。温度每升高10℃,各种原材料的化学反应速度将加快一倍,电池寿命随之缩短一半 [6] 。因此,为保护UPS电池,建议对其进行独立温度处理,使之维持28℃左右。

提高机房温度对服务器的影响

根据ASHRAE Technical Committee(TC)9.9的研究报告,数据中心机房温度升高,服务器的故障率会相应增大。数据中心服务器在几个温度范围内的故障率如表5所示 [7] 。

表5 数据中心服务器在不同温度下的故障率

由表5可见,随着数据中心机房温度的升高,IT设备的故障率上升。该报告还给出一个参考值:如果数据中心机房温度恒定保持在20℃,设备故障率是0.990%。

3.高温数据中心案例

高温数据中心的概念由Intel近年提出,从试验可行性论证、硬件设备研发、整体综合设计、有关标准制定等方面入手,Intel提出一系列技术措施,包括英特尔智能功耗节点管理器、英特尔数据中心管理器、高温环境(HTA)数据中心及功耗和散热感知调度(PTAS)和英特尔服务器电池备份解决方案。笔者整理国内外若干高温数据中心成功应用案例,对高温数据中心的实施进行了论证。

(1)Facebook加利福尼亚数据中心

2010年10月,Facebook对其位于加利福尼亚州圣克拉拉市占地5200m2的数据中心进行了改造。在当年的数据中心效率峰会(Data Center Efficiency Summit)上,Facebook展示了他们的多项改造措施,包括CFD建模分析机房气流和冷热通道气流组织、减少机房空气处理机、降低服务器风机转速及调高机房温度。

Facebook数据中心将机房温度从22.2℃提高到了27.2℃,同时将冷水机组的冷水供水温度从6.7℃提高到了11.0℃。该公司的年度能源开支下降了229000美元,并从Silicon Valley Power获得了294761美元的能源补贴。

(2)Cisco加州圣何塞数据中心

2009年位于加州圣何塞的Cisco数据中心,采用提高数据中心机房温度与冷冻水温度预设值的方法降低数据中心能耗。数据中心机房温度从20℃~22℃经过几个星期慢慢提升到24℃~27℃,冷水供水温度从6.6℃升高至8.8℃。经过测算,该数据中心冷却成本节约了21.9%。相比于其2008年电力消耗数据,每年能够节省200.6万kW·h时的电量。

(3)lntel新墨西哥州数据中心

英特尔在新墨西哥州建立一个名为概念验证(Proof of Concept)的数据中心,共计900台服务器,放置在一个93m2的拖车上。900台服务器被分成两组,一组采用传统空调设备降温;另外一组直接采用室外空气冷却。试验从2016年10月开始一直持续到2017年8月,在长达10个月的时间里,室外空气温度的变化范围为17℃~33℃。机房温度最高为33℃时,在基本没有除尘措施、没有湿度控制的“恶劣”环境下,直接采用室外空气降温的服务器依然正常运行,故障率为4.46%。

(4)北京某数据中心

笔者于2018年7月24日至8月10日对北京酒仙桥某数据中心进行了机房温度提升的节能实施工作。该数据中心总面积2000m2,共1006个机柜,机柜标准功率为2千瓦/台。空调系统形式为电制冷集中冷水系统+free cooling(自然冷却)的形式。

将冷水机组的冷水回水温度由11℃提升至12℃,实地测量机房内部冷通道平均温度和局部热点平均温度。温度提升前,1号~5号机房冷通道的平均温度分别为18.0℃,18.0℃,20.5℃,18.9℃和19.1℃,局部热点平均温度分别为24.4℃,19.9℃,24.3℃,20.4℃和24.2℃。温度提升后,1号~5号机房冷通道的平均温度分别为18.4℃,18.4℃,20.9℃,18.3℃和19.5℃,局部热点平均温度分别为24.7℃,19.7℃,25.0℃,20.7℃和24.5℃。冷水机组冷水出水温度提升1℃,机房冷通道平均温度升高0.4℃,冷通道顶部局部热点的平均温度为23.8℃,冷通道顶部平均温度为20℃左右,满足服务器安全稳定运行的要求。

从测试结果看,冷通道不同位置的温度在20℃~24℃之间,局部热点和温度不均匀现象仍然存在 [8] ,原因主要有:

(1)冷空气经过地板下的通道送达到远程机柜时风量减弱,再加上高架地板下通常布满电缆线以及管路,阻碍冷空气的传送,造成热点(hot spot);

(2)单个机柜对应的穿孔地板的送风量与机柜内IT设备所需的风量不匹配;

(3)水平和垂直方向热负荷与制冷量的匹配度;

(4)机柜孔密度与设备风量的匹配,匹配调整穿孔地板开孔率,测量送风量,按设备需求量供给;

(5)机柜底部与静电地板间缝隙的存在,会出现热气流从该缝隙回流至冷通道,造成热点;

(6)同列相邻机柜间空隙的存在,使得冷热气流隔离效果不好,引起冷热气流混合,造成冷量的浪费及热气流的回流。

改造项目重点记录冷站中冷水机组的运行电流,测量结果表明,冷水机组冷冻水出水温度提升前后,冷站内冷水机组的总用电量从429.3kW下降到409.6kW。

另外,北京工业大学周峰等对北京市某公共机构数据中心机房进行节能改造,实际测试及计算分析结果表明,改造后数据中心机房全年节能率可达22.7% [9] 。

4.结束语

随着数据中心的发展,其能源消耗问题受到关注。高温数据中心是近年来出现的节能数据中心设计理念。该概念虽然提出不久,但在世界范围已有比较成功的案例。这些案例表明,合理提高数据中心机房温度能够降低能耗,且不会引起服务器运行安全问题。

[1]KYATHSANDRA J.The efficient data center,improving datacenter efficiency through intel technologies and high ambient temperature operation[J].Chuck Ergo Intel DCSG Marketing,2011(7):36-40.

[2]韩武松,郑坤,满孝新,等,上海某数据中心空调系统设计[J].暖通空调,2016,46(8):74-79.

[3]数据中心设计规范:GB 50174—2017[S].

[4]Telecommunications infrastructure standard for data centers:TIA-942-2010[S].

[5]ASHRAE Technical Committee(TC)9.9 Mission Critical Facilities.Technology spaces,and electronic equipment[R]∥2011 Thermal Guidelines for Data Processing Environments-Expanded Data Center Classes and Usage Guidance Whitepaper.2011.

[6]张广明,韩林.数据中心UPS供电系统的设计与应用北京[M].北京:人民邮电出版社,2008.

[7]吕爱华,梅胜,杨晓生.数据通信机房空调通风系统的实验测试分析[J].建筑节能,2010,38(2):29-31.

[8]鞠学松.数据中心散热问题解决方案的探讨[J].UPS应用,2011(2):53-58.

[9]周峰,王绚,马国远.数据机房泵驱动自然冷却机组工程运行节能分析[J].制冷与空调,2016,16(11):72-76.