本帖最后由 liming063322 于 2013-9-4 09:26 编辑 谷歌公布了其在2010年全年的数据中心耗电情况。根据谷歌提供的数据,这家互联网公司一年的电力消耗量高达近23亿千瓦时,比21万个美国家庭一年的用电量加一块儿还要多。据斯坦福大学的JonathanKoomey估计,截至2010年底,谷歌共拥有近90万台服务器,约占全球3%的服务器数量,但只使用全球数据中心1%的电力,目前其部分数据中心的年均PUE约为1.12左右,显然谷歌数据中心的运作比其他数据中心更为高效。我们知道除了制冷系统外,数据中心的供电系统也是能耗很大的一块,因此有必要研究一下其供电系统,虽然不一定适合中国国情和一般用户,但其理念和思路却是非常值得借鉴的。

谷歌公布了其在2010年全年的数据中心耗电情况。根据谷歌提供的数据,这家互联网公司一年的电力消耗量高达近23亿千瓦时,比21万个美国家庭一年的用电量加一块儿还要多。据斯坦福大学的JonathanKoomey估计,截至2010年底,谷歌共拥有近90万台服务器,约占全球3%的服务器数量,但只使用全球数据中心1%的电力,目前其部分数据中心的年均PUE约为1.12左右,显然谷歌数据中心的运作比其他数据中心更为高效。我们知道除了制冷系统外,数据中心的供电系统也是能耗很大的一块,因此有必要研究一下其供电系统,虽然不一定适合中国国情和一般用户,但其理念和思路却是非常值得借鉴的。

由于篇幅有限,变电站及中压部分就不再展开,但其总体思路是采用中压配电输送到机房周边,靠近负载就近经变压器降压成低压,再通过低压母线输电到机房内的IT机柜上。从图1我们可以看到模块化的户外型变压器及低压配电柜环绕机房周边,采用集装箱型的柴油发电机组作为变配电的供电投切备份,柴发风管直立到屋顶上排风。经过变压器变压后的市电通过母线槽或者线缆直连到机房内的机柜上方,直接给自带分布式UPS的服务器供电。

如图是谷歌数据中心内部的俯视图,从这个照片我们可以看到市电经前面描述的室外变压器降压后直接通过母线槽的方式架设在每排机柜顶部,再用机柜顶部的配线盒连接到每个机柜PDU,具体细节我们后面会介绍。由于谷歌定制的服务器上自带有分布式小UPS,因此谷歌的数据中心内部不再有UPS室和电池室等,也没有列头柜等二次配电环节,每个服务器直接采用市电直供技术,达到接近99.9%的供电效率。如图3(a)所示的每个机柜直接从机柜顶部母线槽上安装的配线盒取电,这种供电架构非常简单清爽,大大减少了线缆的采购和工程施工,而且非常灵活便于机柜扩充和带电检修维护等,运营起来也非常简单,还可以根据机柜的功率和用电可靠性情况灵活调整配线盒来满足不同设备的供电需求。此外,变压器、中低压以及柴发供电外置,且无集中UPS和电池等,机房内的空间利用率也非常高。

谷歌的带小UPS的市电直供服务器大家都应该非常了解了,这里不再详述,只简做要介绍。其原理是在服务器内安装底部的12V黑色铅酸电池用于市电停电保护,市电正常时候,由于没有外部UPS,市电直接给服务器供电,达到99.9%的供电效率;当市电停电后,直接挂接在12V输出上的电池短时放电,直至室外的柴发启动恢复服务器电源带载。电池参与放电的时间基本不到一两分钟,因此电池的容量很小,大约只有3.2Ah,备电时间远远小于传统数据中心15到30分钟的电池备电需求,因此对柴发的启动要求很高。

我们前面知道谷歌的柴发是模块化直接安装在变压器旁边的,很有可能是低压柴发,其启动很快。而且每台柴发对应一个变压器,没有复杂的柴发并机以及启动时序等问题,因此正常情况下柴发启动时间可以控制在十几秒以内,一两分钟的电池备电时间基本上是够了,但这对运维水平要求就非常高了。当然谷歌的软件架构和业务备份方面也足够强壮,甚至部分设备停电也不会影响到业务正常运行,因此只有强大的技术实力才可以采用这种供电架构。

如图是谷歌三联柜102a-c的正视图,以及顶部配电系统100,后者不仅给三联柜服务器供电,还给相关的空调等支撑设备供电,比如机柜顶部的风扇等。三联柜底部装有滚轮105,用于支撑机柜,并且方便现场运营人员灵活搬运,每个机柜高度约为30个导轨,估计每个设备高度约1.5U,总计高度45U左右,整个三联柜总共有90个设备安装空间。这种设计使得整个三联柜不会太高,无需凳子或者梯子等来协助。三联柜横向宽度方面也不会太宽,叉车等工具可以简易搬迁,甚至现场安装人员可以徒手在数据中心内很容易搬动到需要的地方。

空气循环单元107会被安装在背靠背的两组三联柜之间,该单元包含两组三联柜之间的锁固框架,以及一到两个的空调盘管,还有热通道顶部的一些风扇等。三联柜排出的热空气可以进入框架内,然后被空调盘管制冷,最后从顶部的风扇被吹回整个机房冷环境中。空气循环单元107的框架上还架设有支撑架108,支撑架108用于安装线槽110和112等,分别用于布设供电线缆和光纤或铜缆等。空气循环单元上还有一些网线等,用于控制风扇的转速,并将收集到的压力、温度、设备故障信息等送回到机房监控中。

三联柜顶部的配电系统100则包括IT机柜供电的配线盒116,该配线盒向上可通过118接入口从一根或者两根供电母排上获得电力,向下则通过配电空开122以及线缆120等给102a-c的三联柜每个机柜分别供电。比如每个机柜有三根线120到机柜PDU,那么122配电空开就总共有9个微断连接到9条输出线缆120上,或者3个3P的空开。

由于三联柜通常都是工厂预制并安装好TOR的整机柜,当三联柜被滚动安装锁固在空气循环框架107后,就可以直接从线槽110或者112上连接上联光纤。然后供电的配线盒116向上则从供电母线取电,向下则给三联柜机柜的PDU供电。最后等所有的线缆都连接好并带电后,三联柜内的服务器上电开始加载系统开始工作。如前面所述,每个机柜有30个导轨安装30台服务器,每个机柜采用三相空开,每相空开带载10台设备,每组三联柜共有9路输出空开,如果任何部分发生故障,那么最多也只会影响到1/9的设备,在保证人身安全的同时,尽量缩小故障影响面。

图6(a)是PDU及机柜一角的俯视图,其中302是用于支撑待安装服务器的导轨,而304则是PDU的支撑架,用于固定垂直的PDU306到机柜上。PDU内部包含三根导线308、310和312,每根导线连接PDU上1/3的插座,比如导线312连接到PDU顶部的10个插座314,310负责中间的10个插座,而308则负责底部的10个插座。图6(b)则描述了服务器主板316被安装在导轨302上,以及和PDU的电源线连接示意。服务器316通过电源线320以及电源插头318从PDU上取电,当然这里电源线只是示意,实际上谷歌的服务器电源往往安装在热通道侧,电源线穿过服务器到机柜前面的冷通道来取电,满足谷歌服务器全正面冷通道维护的需求。图6(c)更为详细的展示了导轨302和PDU306之间的位置,插座314和导轨302一一对应逐个匹配,所以服务器电源线可以就近很好得连结到每个插座,当然如果有需要,也可能会有冗余的插座用于安装其他需要的设备,比如交换机等。

图7是PDU的示意图,整条PDU分为6个子部分,从402到412,每个子部分则包含5个插座。当然也可以分成其他数量的子部分和不同的插座数,但每个子部分之间是没有直接电气连接的,且每个部分会设置有独立的空开或者熔丝等来保护该子部分。标识为418、420和422的三个插座是三个电气连接口,用于整条PDU从低压母线排上的配线盒来取电。比如前面的例子,418输入的电源线会覆盖到2个PDU子部分,共连接10个插座。同样的,420和422输入也各覆盖10个插座。PDU上还安装有部分的熔丝保护槽414,用于安装和快速更换熔丝。比如,图7中414熔丝槽内的熔丝可以用于保护和隔离406部分的5个插座。如果406子部分5个插座的总负载电流不超过15A,那么418的输入线缆会选择载流量为30A的电源线,整条PDU则可以承载3*30A的IT负荷。在230Vac到240Vac供电情况下,418输入会选择10AWG或者4mm^2的线缆。根据谷歌服务器300到400瓦的典型功率,单机柜功率约在9-12KW附近。此外,上级配线盒内会选择容量较大,而且动作响应时间较慢的开关,这种情况下靠近负载的熔丝会在故障发生时先于上级的开关动作,快速切断负载,并且确保不会影响到上级开关,这种上下级开关和熔丝的选择性问题会在后面详细描述。

图8是标识为600的PDU内部电路图,包含三根导线602、604和606,每根导线及其分支都会连接到共两根熔丝上,每根熔丝又覆盖5个插座,这样每根导线覆盖10个插座。每根熔丝的载流量也不能选择过大,以至于不能保护其上级连接的线缆和空开等。比如导线602的上级空开为30A的微断,那么熔丝就必须选择小于15A的,这样确保两根熔丝的载流量不会超过上级空开30A的分断能力。同时选择快熔型熔丝,以保证机柜PDU内配置的熔丝动作时间小于配电箱内上级微型断路器的动作时间。5个插座对应1个熔丝,熔丝槽设计便于熔丝维护更换,以减少修复时间。采用这种一根熔丝只带5个插座的设计,保证了任意一台服务器的电源短路故障只会影响到该子部分的5台服务器,避免该短路故障扩散到整个机架。同时熔丝可在PDU的熔丝槽内快速更换,也减少了被影响服务器的故障修复时间。

图9(a)展示了带9P空开的配线盒正视图,输入线缆706可从母排或者配电柜取电,其线径可选择AWG2号线或者载流量达到100A的线缆。配线盒面板上有9个型号为LevitonL6-30R的输出母头和9P控制空开。配线盒侧面还有个线缆捆扎钩720,用于输出线缆的捆扎整理,线缆美观的同时还能减少下垂线缆的重量对配线盒的拉伸应力。图9(b)则展示了配线盒内部的配线排细节,比如输入配线排将输入的三根火线分配到9个空开上,还有中线排和地线排等用于9个支路的输出,并且接地排同时还会连接到配线盒外壳上作为接地保护。图9(c)则是配线盒的侧视图,展示了输出线缆如何挂接在线缆钩上,减少线缆重量对线缆输出接头的拉伸应力。这种配线盒设计有效节省了机房空间,并满足快速部署需求。

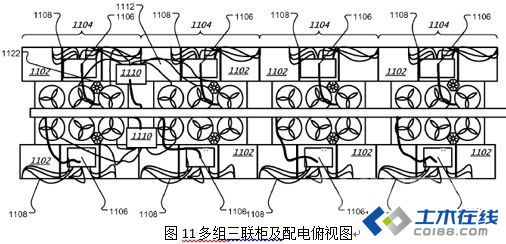

图10是四组三联柜以及顶部配电盒的示意图,每组三联柜1002从机柜顶部带9路输出的IT配线盒1006上取电。除此之外,三联柜顶部还有另外一个带12路输出的空调配线盒1010,用于给背靠背两排机柜间热通道顶部的置顶空调风机供电,后面会有详细介绍。